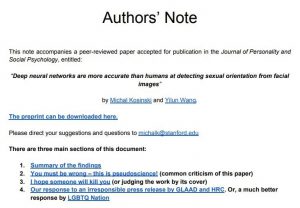

原标题:「AI识别的是同性恋,警醒的是所有人的隐私安全」,斯坦福作者回应论文争议

雷锋网 AI 科技评论按:上周,斯坦福一篇识别同性恋的论文引起了轩然大波。

这是一篇用深度神经网络识别同性恋的论文,即将要发表在美国心理学会的「人格与社会心理学」期刊上,然后上周突然火了起来。

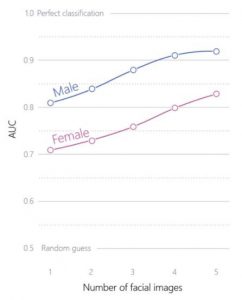

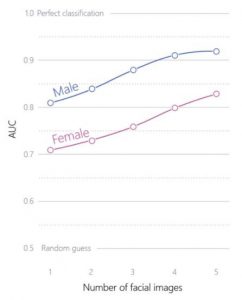

面前有一张同性恋和一张异性恋的照片,论文中的方法可以识别人脸的面部特征,然后从两张里挑出更可能是同性恋的那一张(即AUC)。这样挑男性照片的正确率有81%,挑女性照片的正确率则有71%。相比之下人的表现只有61%和54%,比从两张里随便选一个(50%正确率)好不了多少。

假如每个人有多张照片,挑出同性恋的正确率还能继续提升:在每个人5张图像的情况下,从两个人里挑出同性恋的正确率可以继续提升到男性91%和女性83%。

(注意,上面所提及的这几个数字都是AUC,和“识别正确率”不相等,后文有详细解释)

如此明确的结果马上引起了国内外媒体和民众的热烈讨论。除了表示震惊和担忧可能引起的隐私问题,还有人就是不喜欢这个结果,给作者们发去了人身威胁的邮件。作者也非常耐心地写了一封公开信来一一答复各种意见。不过在细说这封公开信之前,我们先来回顾一下论文的主要内容如何。

论文内容

以前各国学者就对“性格是否会影响容貌”做过许多讨论,近年也有研究提出了孕期的荷尔蒙水平会影响胎儿性取向的说法(PHT,prenatal hormone theory)并被广泛接受,似乎可以说明性取向和面部发育之间有所关联。另外,人们普遍相信同性恋发现其它同性恋的能力比异性恋要敏锐得多,这也说明了人们确实觉得同性恋和异性恋会看起来有所不同,才更容易被具备类似特质(性取向)的人发现。

那么计算机,或者说深度学习能发现同性恋和异性恋之间的区别吗?如果有区别,这些区别又是什么呢?作者们就借这篇论文做了一些探索。

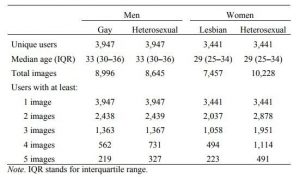

他们首先去美国某个婚恋网站上找照片。婚恋网站上的人没必要对性取向说谎对不对,这样他们就采集到了来自36630个男性和38593个女性的一共30万张照片,其中同性恋和异性恋各一半。借助旷视科技的Face++把合影、面部不全、面部太小、没有面向相机的照片去掉以后,还剩下35326张符合需求的。

找好了照片,接下来要设计模型了。由于作者们并不是计算机系的学生,所以他们先直接选取了一个2015年提出、而后得到广泛使用的深度神经网络人脸识别模型 VGG-Face,用来提取高维人脸特征。VGG-Face 的本意是用来识别确认不同图像里是不是同一个人的,所以它对照片中表情、背景、光照等因素的敏感性较低,这正是作者们需要的;另外他们直接用了经过260万张照片训练过的 VGG-Face 模型,也可以避免自己训练模型导致过拟合。

VGG-Face 中会把一张照片转换为一个4096维的向量,也就是4096个子项分数。作者们用奇异值分解(SVD)降维到500维以后,把这500维的值看作是500个独立变量,与照片中人的性取向合起来建立了一个线性回归模型,作为他们的预测分类器。所有照片中的95%用来训练这个预测分类器,然后用另5%做验证测试。

结果1

作者们得到的第一个结果就是文章开头的数据,从一张同性恋和一张异性恋的照片里挑出同性恋的那个人(AUC),对男性的正确率有81%;挑女性照片的正确率则有71%;有5张照片的时候,AUC 可以继续提升到男性的91%和女性的83%。这就有力地说明了人脸有更多隐含的信息,人类自己可能没法感知和表达,但这些信息是切实存在的。

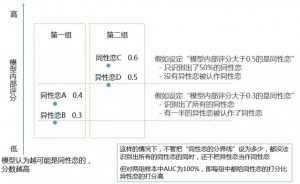

(雷锋网 AI 科技评论补充科普:“AUC”和一般意义的“识别正确率”不能直接相等。AUC的全称是Area under curve,指的是ROC曲线下方的面积。这个值形容的是模型给样本中的正例打分高于负例的概率。

详细解释是这样的,识别方法(线性回归模型)内部会首先对样本打分,分数范围是0到1之间,再根据设定的标准输出结果。由于人脸的细节很多,作者们选用的独立变量也多,模型的内部打分也会有很大波动。

假设从已确定性取向的人里选出一个同性恋A和一个异性恋B,模型可能认为A是同性恋的可能性为0.4,B是同性恋的可能性为0.3;另一组同性恋 C 和异性恋 D 可能分别打分0.6、0.5。“识别正确率”和“AUC”的对比如下图:

可以看到,同一个模型、一样的打分能力,识别正确率根据不同的标准可以有很多不同的值;实际中又往往也找不到那个没有误判的标准。所以“识别正确率”并不是一个足够准确的评价标准。

“识别正确率”在某个分类的出现概率很小时也不能使用。假设某罕见病的发病率为0.1%,那么随便指着街上来来往往的人说他们都没病就可以达到99.9%的诊断正确率;但这个诊断正确率对真正得病的病人是无济于事的。

而模型在每一组二选一里都选对就会表现为更高的AUC,也就是从一张同性恋和一张异性恋照片里正确挑出同性恋的那张,这不受前述的判别标准和出现概率的影响。所以高AUC确实代表模型的识别能力更强,但是和识别正确率又不直接相等。作者们得出的“男性81%”、“女性71%”的AUC不代表“识别是否为同性恋”的准确率就是这么高。)

结果2

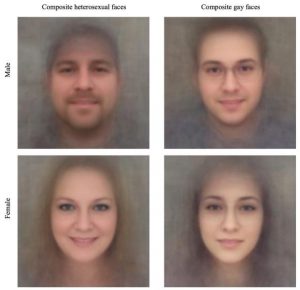

作者们并没有满足于高AUC的结果,既然模型能找到同性恋和异性恋之间的区别从而把他们分开,那么这些区别是什么呢?作者们就从每组照片中抽出100张,生成一张综合的脸,看看区别在哪里。结果同样很明显,看下图

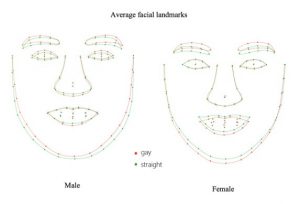

还有一张提取出的特征点对比图

作者们分析得到的结论是,同性恋的脸型上体现出的典型性别特征更少。根据生成的“平均脸”,男性同性恋的下巴更窄、鼻子更长;女性同性恋则下巴更宽。

除了脸型之外,其它面部特征也有区别。跟异性恋相比,男性同性恋面部的毛发更少、肤色更浅,这和毛发生长速度、清洁习惯、晒太阳都有关系;女性同性恋则眼妆较淡、发色更深、衣服也更保守(可以从图中看到更高的颈线),这都减少了典型性别特征的体现。

还有一些有意思的区别,总的来说女性比男性更爱笑,但是女性同性恋就比女性异性恋笑得要少;以及,在美国文化中棒球帽通常给人带来更有力量的感觉,所以男性中异性恋戴帽子更多,女性中同性恋戴帽子更多(注意“平均脸”额头附近的阴影,作者们也实际看了那些用到的照片确认了这一点)。这仍然是“同性恋具有更少的典型性别特征”的体现。

结果3

为了从另一个角度验证“同性恋具有更少的典型性别特征”的结论,作者们用2015年的 myPersonality.org 的290万张 Facebook 用户照片训练了一个神经网络性别分类器,方法和前面一样,只是这次只判断性别。训练以后让模型识别来自婚恋网站的那些照片,AUC达到了98%。

作者们分析了这个模型的识别结果,也发现男性同性恋的脸更为女性化,而女性同性恋的脸有更强的肌肉感。

结果4

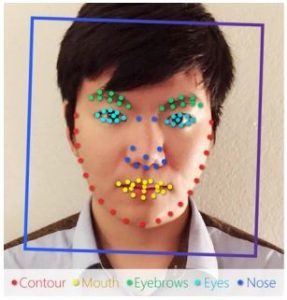

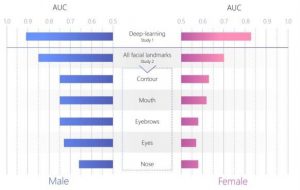

“结果2”中的对比图已经说明了同性恋和异性恋脸型确实有区别。那么用脸型中的某个指定特征来预测性取向的结果如何?作者们用脸上的特征点分别计算了脸上特征的大小,然后为不同的特征分别训练模型尝试挑出同性恋。这里每个人用了5张照片。

结果如下图,对男性来说,只用脸的外轮廓(Contour)就可以达到75%的AUC,其它几个特征的AUC也很高,非常显著;女性则不明显一些。五官的特征点都利用起来,男性的AUC上升到了85%,女性的也有70%。而原始VGG-Face模型输出的4096维向量具有最全的信息,不仅限于五官的特征,基于它的AUC就是最高的91%和83%。

前面的结果都已经有力地表明了可以从图像中找到足够多的线索来推测一个人的性取向。不过作者们也开始担心,由于用到的照片是来自婚恋网站的,这些照片中的性吸引力会不会被放大了,才让同性恋和异性恋显得不同呢?作者们又做了两个实验来验证。

结果5

最快的方法当然是让人来判断。作者们从亚马逊众包平台AMT上找了几个完成的任务超过1000、且接受率高于98%的人来做判断,可以认为他们的结果可信度是很高的;同样,对于随机选出的一张同性恋照片和异性恋照片,他们要挑出其中同性恋的那个。

人类的结果是男性61%正确率和女性54%正确率,这也和以往多个研究中得到的55%~65%的准确率相符。这个结果说明论文中用到的婚恋网站照片并没有额外的吸引力;而且人类判断男性的正确率更高,这也和神经网络的表现相符。

结果6

是时候测试模型的泛化能力了,用其它来源的照片得到相似的结果也能说明方法和原来的图像的有效性。他们从 myPersonality.org 的 Facebook 用户照片集中找出了6075个男性同性恋的14438张照片,用前文同样的方法实验后,得到了74%的AUC。

他们还做了一个反向验证,让模型分辨一个人是来自婚恋网站还是Facebook的,模型的AUC只有53%。这也说明了模型对人脸所处的环境不敏感,它确实只提取了人脸本身的信息。

对结果的讨论

面对以上的结果,作者们也在论文中表达了自己的想法:

这一系列实验的结果表明了人脸含有很多信息,有些信息人类自己没法清晰地感知和表达,但是深度学习模型可以,这就成为了判别是否是同性恋的基础

根据深度学习结果总结出的面部特征区别,也和现有的解释同性恋形成理论(PHT)有相符之处

发现了性取向和面部特征之间的联系,可以给研究人类的某些社会活动和自然特性带来更多的研究对象

同时很重要的是,他们不希望读者错误地解读了论文中的结论

同性恋的“平均脸”中具有更少的典型性别特征,并不代表所有的同性恋都是这样,外表看起来非常像异性恋但实际是同性恋的人是必然存在的。论文中只是发现了一些微小、比较常出现、在“平均脸”上才比较明显的特征。

深度学习能够有效挑出同性恋,不代表人类也能有效判断。论文中的结果就表明了,即便知道深度学习取得了很好的表现,人类的判断还是不怎么准。

以及,不要把论文中展示结果用的AUC和一般意义上的“识别正确率”混为一谈(这个上文有讲过,还没分清的读者可以再看一遍)

在论文结尾,作者们也表示了对隐私的担忧:以往有研究可以通过人在社交媒体上的行为判断他/她是否是同性恋;可能这些行为可以隐藏或者删除,但是人脸的特征是没办法轻易改变、也很难隐藏的。如今各处都有越来越多、越来越高清的监控摄像头,人们的照片在社交媒体、云服务商、政府数据库中存储得也越来越多,社交媒体上的照片还往往可以供任何人看到。这样一来,如果有人建立了准确的同性恋识别系统并把它投入应用,就会成为一场灾难。

作者们之所以选择公开自己的研究成果,就是在信息时代给大众敲响警钟;当前也已经有企业和政府联手设计部署基于人脸的检测系统。那么,提醒政策制定者、普通大众、同性恋社区这种风险的存在也就是刻不容缓的事情。作者们用的也都是现成的方法、已被广泛使用的数据,并不会给想要开发类似系统的人起到额外的什么帮助,而是展现了简单的方法也可以对隐私问题构成很大的威胁。他们希望他们的发现能够提醒公众和政策制定者考虑如何通过技术和政策降低这种潜在的风险。受过良好教育的、有包容心的人们联合起来为平权出力,“后”隐私时代才能变成一个更安全、更宜居的环境。

激烈反响以及作者发声

这篇论文被美国媒体报道,进而被美国公众了解到以后,马上引发了许多讨论甚至反对的声音。有很多人给作者们写邮件说他们“肯定是弄错了,这是伪科学”,甚至还有人在邮件里写“你们怎么不去死”这样激烈的言辞。作者们也非常耐心地写了一封公开信,回应了收到的各种质疑。

作者们首先重复:他们的目的不是为了造出一个侵犯别人隐私的工具,而是为了验证被政府和企业大规模应用的现有科技是否会对人类中某些群体的隐私造成威胁。很不幸,他们发现确实会。即便反对这项研究的人,也不应当出于对研究内容的反感,就否认这种威胁的存在。作者们自己在发表论文前也担心这项研究会引发注意,花了很多时间考虑这样的研究是否会让潜在的威胁付出水面,但他们最终决定,让人们明确地了解到了这样的威胁,才能够提醒 LGTBQ 群体注意这些威胁、提醒大众注意这些威胁、提醒数字服务提供商更好地保护人们的隐私、提醒政策制定者做出应对。

同时作者们也提醒读者们正确认识论文中数据的意义,AUC并不等于系统识别的正确率(前文解释过)。所以读者们不要过分担心这些结果的直接影响。

有许多人质疑研究结果的正确性,作者们也坦诚,由于收集数据的困难性,他们此次的研究仅限于了白种人,所以白种人中表现出的特质不一定也适用与其它的种族。但是根据这些研究结果不难想到,别的种族中也很可能存在某一些生物性的、发展性的、文化性的因素,导致别的种族的同性恋和异性恋之间也有所不同。但是对于其它“用的照片来自婚恋网站所以不准确”、“人们普遍认为面部特征和性格特质之间没有什么联系”、“你们的算法肯定是受到一些别的乱七八糟的因素影响了”之类的质疑,作者们已经用论文中反复的、交叉对比的实验证明了结果的有效性(参见本文介绍的结果1至结果6),他们也希望质疑者可以先仔细阅读论文中的实验和结果再提出质疑。

还有一些激进的人在邮件里写了“你们怎么不去死”等等咒骂的话,作者们也冷静地给出了回复。对于这样的人,作者们首先希望他们耐心读一下论文,“不喜欢这样的研究结果”并不代表这样的结果不合理;而且这样的结果才能有力地提醒所有人更加注意隐私的保护和相关政策的建立。以及,这项研究并不会直接改变某个个人的生活,但是对全体人类来说,这种威胁是确实存在的。

他们也列出了一条推特上的简短有力的回复:“如果你发现一项热门的科技中隐含着威胁,你会自己对此保密,还是研究它、让同行评议它、并发出警告呢?”